Depuis plus de vingt ans, Wikipedia règne en maître sur le web du savoir libre. Mais l’encyclopédie en ligne connaît aujourd’hui une baisse de -8% de son trafic.

En cause ? Les résumés générés par l’intelligence artificielle et les réseaux sociaux, qui modifient profondément la façon dont les internautes recherchent de l’information. Un tournant symbolique dans l’histoire d’un Internet de plus en plus dominé par des contenus automatisés.

L’intelligence artificielle mange les clics

Selon Marshal Miller, Senior Director of Product à la Wikimedia Foundation, les moteurs de recherche comme Google ou Bing utilisent désormais des systèmes d’IA générative qui répondent directement aux questions des internautes… sans les rediriger vers les sites sources. Résultat : moins de visites sur Wikipedia, même si son contenu reste à la base de la plupart de ces résumés automatiques.

Le phénomène s’est accéléré depuis que Google a déployé son AI Overview, une fonctionnalité qui affiche un résumé généré par IA tout en haut des résultats de recherche. Google affirme que cela amène les utilisateurs à visiter une plus grande diversité de sites, mais les chiffres de Wikipedia montrent une tendance inverse : moins de clics, plus de réponses instantanées.

Dans le même temps, les générations plus jeunes se tournent vers TikTok ou Instagram pour obtenir des explications rapides ou des mini-cours vulgarisés, souvent créés par des influenceurs ou des IA génératives. Autant dire que pour beaucoup, lire un article complet sur Wikipedia n’est plus un réflexe.

Des bots de plus en plus rusés et un trafic à deux vitesses

Wikimedia ne pointe pas seulement les IA. Ses équipes observent aussi une hausse du trafic non humain : des bots de plus en plus sophistiqués qui imitent le comportement de vrais utilisateurs pour extraire les données de l’encyclopédie. Ces robots alimentent notamment les modèles de langage (LLM) utilisés par OpenAI, Anthropic ou Google DeepMind.

LIRE AUSSI : Arthur Sadoun affirme que 73% de l’opérationnel de Publicis est désormais « alimenté par l’IA »

Pour contrer le phénomène, l’organisation a mis à jour son système de détection des bots afin de distinguer plus précisément les visites humaines. Mais une fois les “faux clics” retirés, la tendance est claire : le trafic humain baisse, et ce sont surtout les IA qui “lisent” Wikipedia aujourd’hui.

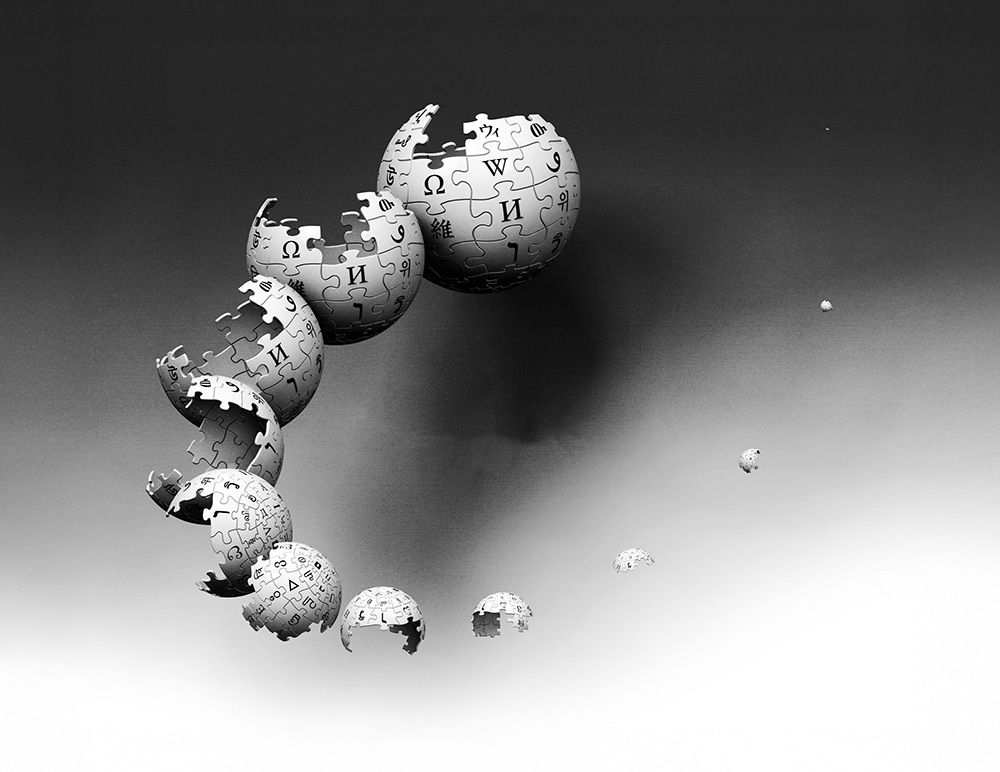

Ce paradoxe illustre un vrai dilemme : Wikipedia reste essentielle pour entraîner les modèles d’intelligence artificielle, mais ces mêmes modèles contribuent à détourner le trafic des utilisateurs humains. Un peu comme un élève brillant qui finit par dépasser son professeur… au point de lui voler la vedette.

Le savoir libre face à la génération IA

Malgré la baisse de trafic, Wikipedia reste l’une des sources les plus fiables et les plus transparentes du web. Près de 80% des grands modèles d’IA actuels utilisent ses données pour s’entraîner. Mais ce nouvel écosystème pose une question de fond : comment garantir la durabilité du savoir libre si les utilisateurs ne visitent plus la source d’origine ?

La Wikimedia Foundation appelle donc les plateformes à mieux attribuer les contenus et à encourager les internautes à consulter les pages sources. Car moins de visites, c’est aussi moins de dons et moins de contributions bénévoles, le moteur même du projet.

Pour rester pertinente, l’organisation explore de nouvelles pistes : outils d’attribution, partenariats éducatifs, présence sur les réseaux sociaux et formats adaptés à la jeune génération. L’objectif : continuer à diffuser le savoir là où se trouvent les gens, sans trahir l’esprit d’origine du projet.

Dans un Internet saturé d’IA, la bataille de Wikipedia n’est pas seulement une question de clics, mais une lutte pour préserver la culture de la vérification et du collectif. Parce qu’à force de déléguer nos réponses à des algorithmes, on finit peut-être par oublier d’où viennent les bonnes questions.

LIRE AUSSI : Pinterest devient le premier réseau social à filtrer les images générées par IA