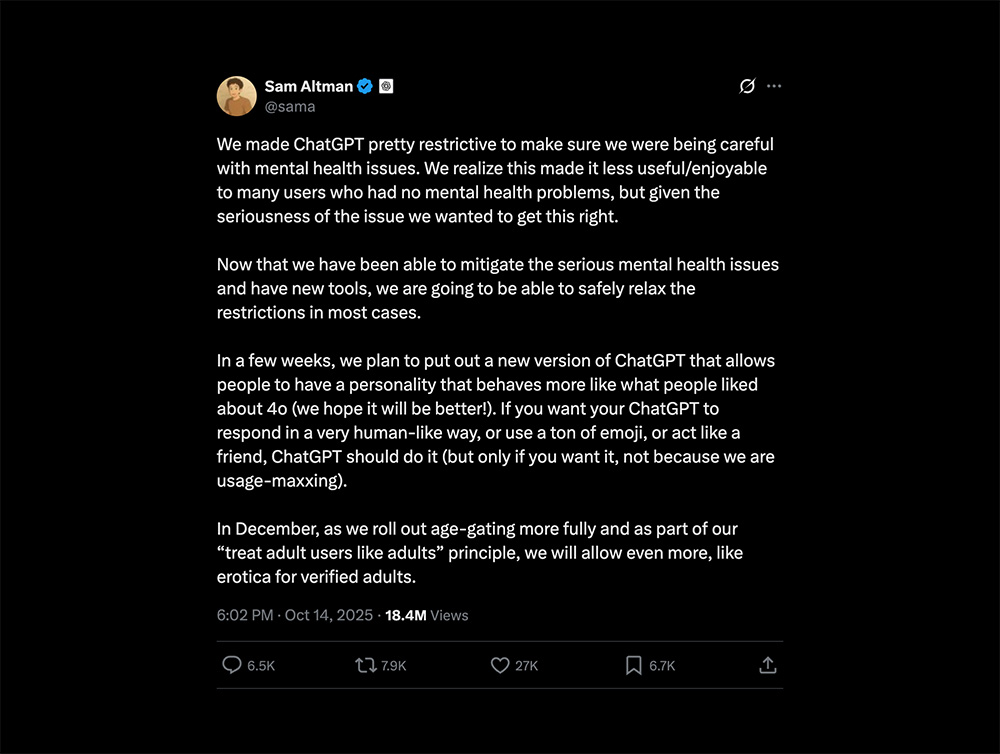

C’est officiel, Sam Altman veut rendre ChatGPT un peu plus “humain”. Le PDG d’OpenAI a annoncé sur X que la plateforme permettra bientôt aux utilisateurs adultes vérifiés d’avoir des conversations érotiques avec le chatbot.

Une décision qui divise autant qu’elle intrigue, et qui marque un tournant dans la stratégie d’OpenAI : moins de prudence, plus de liberté.

L’annonce intervient après plusieurs mois de débats autour des dérives psychologiques liées à l’usage de l’IA conversationnelle. Mais Altman semble confiant : selon lui, OpenAI aurait “atténué les problèmes de santé mentale les plus graves”. De quoi ouvrir la porte à une version de ChatGPT plus “authentique”… et visiblement plus sensuelle.

ChatGPT passe en mode “adulte consentant”

D’ici décembre, OpenAI prévoit de déployer un système d’âge vérifié pour ses utilisateurs, un dispositif déjà en test sur GPT-5 depuis la rentrée. L’idée est simple : permettre aux adultes d’accéder à des fonctionnalités plus permissives, dont les fameuses conversations érotiques. Les mineurs, eux, seront bloqués par une IA de détection d’âge couplée à une vérification d’identité.

Ce choix s’inscrit dans la philosophie assumée d’OpenAI : “traiter les adultes comme des adultes”. Une approche plus libérale, qui tranche avec la prudence extrême du lancement de ChatGPT en 2022, quand la moindre question sensible déclenchait un refus automatique.

Mais derrière le vernis de liberté, l’initiative soulève des questions éthiques. La frontière entre érotisme et addiction émotionnelle avec une IA reste floue. Les concurrents comme Character.AI l’ont déjà prouvé : les interactions romantiques ou sexuelles sont un puissant levier d’engagement, mais aussi un terrain glissant. En 2023, certains utilisateurs passaient plus de deux heures par jour à discuter avec leurs chatbots, au point d’y développer une forme de dépendance.

Entre stratégie business et zone grise morale

Avec plus de 800 millions d’utilisateurs hebdomadaires, OpenAI doit désormais transformer l’essai. Son infrastructure coûte des milliards, et la société doit justifier ces investissements face à Google et Meta, qui misent eux aussi sur des IA conversationnelles ultra personnalisées.

L’ouverture au contenu érotique pourrait bien être un moyen de doper la rétention sur ChatGPT, tout en séduisant une communauté déjà présente sur d’autres plateformes. Altman jure pourtant ne pas chercher à “maximiser l’usage” mais à “rendre l’expérience plus naturelle”. Une promesse difficile à croire quand on connaît la bataille acharnée pour garder les utilisateurs engagés dans l’écosystème OpenAI.

LIRE AUSSI : Wikipedia perd 8% de son trafic à cause de l’IA et des réseaux sociaux

Ce tournant s’inscrit d’ailleurs dans une stratégie plus large d’assouplissement de la modération. En 2024, OpenAI avait déjà ajusté ses règles pour autoriser des sujets auparavant sensibles, allant des discussions politiques aux représentations d’images controversées. Cette nouvelle étape s’inscrit donc dans une logique assumée : donner plus de liberté à l’utilisateur, quitte à frôler la ligne rouge.

Une IA plus humaine… ou plus dangereuse ?

Si cette évolution peut sembler naturelle dans un contexte de “maturité” de l’IA, elle reste inédite pour une entreprise grand public comme OpenAI. Contrairement aux plateformes spécialisées dans le “chat romantique”, ChatGPT s’adresse à un public large, incluant étudiants, professionnels, enseignants et mineurs.

Et c’est bien là que le bât blesse : comment garantir qu’aucun mineur n’accède à ces fonctions ? Et surtout, que ces échanges ne deviennent pas un nouveau substitut émotionnel pour les personnes vulnérables ?

OpenAI dit vouloir encadrer ces pratiques grâce à son conseil d’experts en santé mentale et à des outils de détection des comportements à risque. Mais ces mesures restent floues, et les précédents montrent que les IA, même encadrées, peuvent très vite échapper à leur créateur.

Une chose est sûre : avec cette décision, Sam Altman brouille un peu plus la frontière entre technologie et intimité. ChatGPT ne sera bientôt plus seulement un assistant, mais aussi un confident, un partenaire de conversation… et peut-être, pour certains, un partenaire tout court.

LIRE AUSSI : Arthur Sadoun affirme que 73% de l’opérationnel de Publicis est désormais « alimenté par l’IA »